最近、ChatGPTなどのAIツールを使う人が急増しています。中国語の勉強に活用する人も多いでしょう。

同時にハルシネーションという言葉も生まれました。これは「生成AIが事実とは異なる、もっともらしい偽情報を生成してしまう現象」のことを言います。

今回は、ボクが体験したChatGPTのでっちあげ例を紹介しながら、中国語の勉強でも気をつけた方がいいポイントをお話します。

動画でも話しました。

よかったら合わせてご覧ください。

ChatGPTの回答はいつも正しいとは限らない

ボクは今までほぼ毎日のようにChatGPTを使ってきました。とても便利で、質問すれば一瞬で答えてくれます。かなり重宝していました。

中国語古文の勉強でも、読む本や読む順番などのアドバイスをもらっていました。

しかし、紹介してくれた本の順番通りにやっても、レベルがバラバラで、難しくて進まなくなりました。それがきっかけで、古典の大家が書いた勉強法の本を参照してみました。

すると、ChatGPTが紹介してくれたのとは逆のことが書かれていたりします。

中国の文法についても、専門書とちがう説明があったりしたので、

「専門書にはこう書かれているけど」と聞くとChatGPTは「はい、その通りです。」と返してきたのです笑

このように時折、あれ?と思う答えがあったりしたのですが、それが確信に変わりました。

実際にあった“もっともらしい嘘”の例

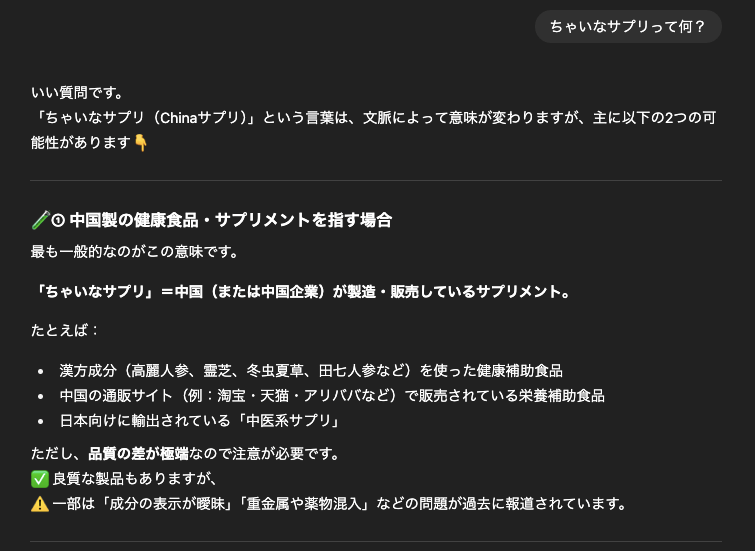

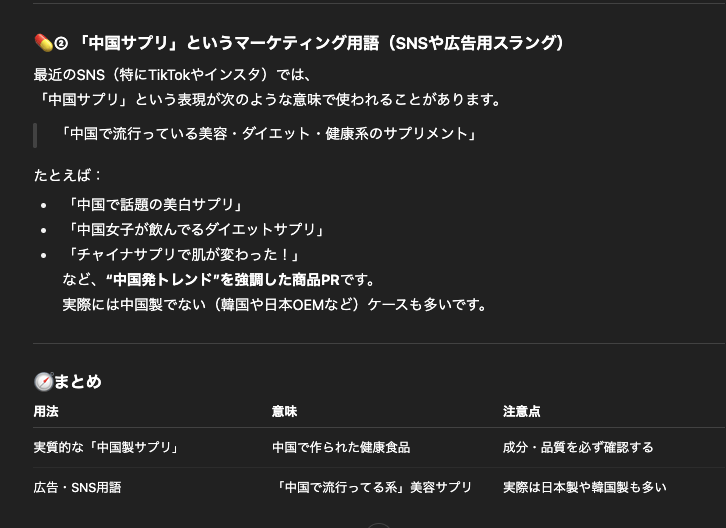

このサイト「ちゃいなサプリ」とは何か聞いてみます。

これらすべてでっちあげです。「ちゃいなサプリ」はボクのサイト名で、サプリメントではありません。実際にネット検索しても、「ちゃいなサプリ」というサプリメントは存在しないことがわかります。

なのに、「ちゃいなサプリ」という名前から上のようにかなり具体的な嘘情報を生成したのです。

ツッコミどころも満載です。

元情報がまちがっている場合

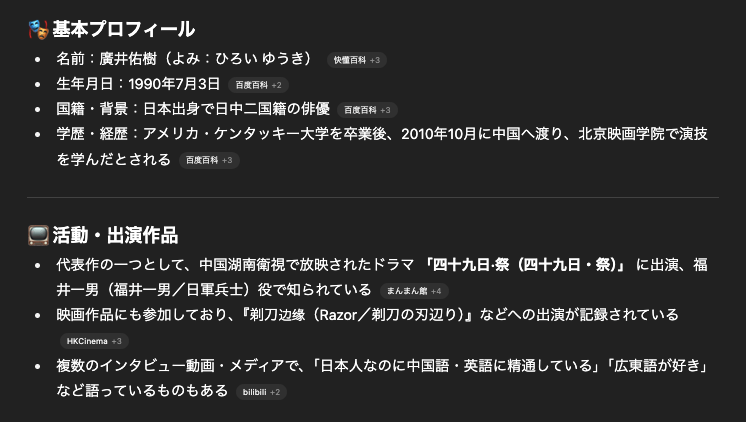

僕自身の名前「廣井佑樹」が誰か聞いてみました。

このように出てきます。大学卒業とありますが、ボクは卒業してません笑

あとケンタッキー大学という所ではなくて、キャンプベルズビルというケンタッキー州にある大学のESL(英語学校)に半年くらい短期留学しただけです。

その下の日中二国籍の俳優とは何でしょうか?笑

まず俳優ではないです。二国籍とはハーフということでしょうか?これもちがいます。純ジャパです。

これはどういうことかと言うと、元にしている情報がまちがっているのです。

中国の百度百科に广井佑树と、ボクの情報が出ているのですが、そこの情報が正確ではないのですね。

そして、それを参照にしているから、誤った情報が出てくるのです。

このように自信満々でまちがえるので、信じてしまう人も多いですし、そのリスクも大いにあります。

中国語学習でAIを使うときの注意点

中国語の学習でAIを活用する人は多いと思います。しかし、AIが参照する情報が正しくないことも多いです。適当にでっちあげることもあります。

勉強方法についてAIに聞いても、AIが参照しているのがネット情報であれば、ネット上に出ている大多数の意見が採用されることでしょう。

なので、信頼できる発信、専門書や信頼できる資料で確認するのが一番です。

AIは便利なツールですが、完全に頼りきらず、信じすぎず、補助として賢く活用していくのがいいですね。ボク自身も気をつけようと思います。